TL;DR

|

Resumen

La rápida evolución de la Inteligencia Artificial Generativa (GenAI) ha catalizado cambios transformadores en diversas industrias, lo que exige el desarrollo de marcos robustos que satisfagan las crecientes demandas de eficiencia, seguridad y riqueza de características. Langchain ha surgido como una plataforma destacada para los desarrolladores que buscan construir e implementar aplicaciones GenAI, con más de 93,2 mil estrellas en GitHub y más de 20 millones de descargas. A pesar de su adopción generalizada, la creciente complejidad de los proyectos de IA subraya las limitaciones inherentes a los marcos existentes como Langchain, particularmente en lo que respecta a la velocidad, la simplicidad y la seguridad.

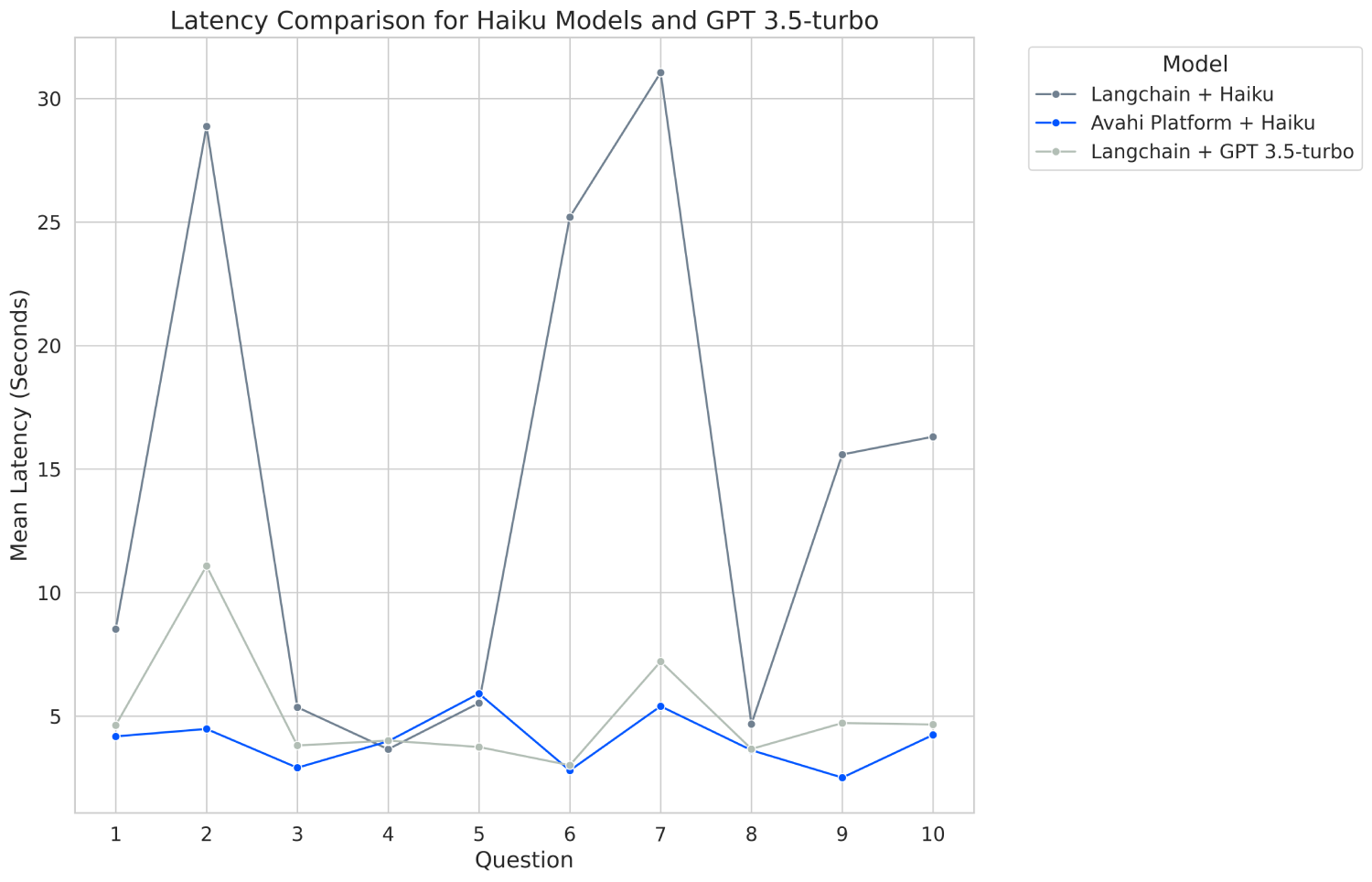

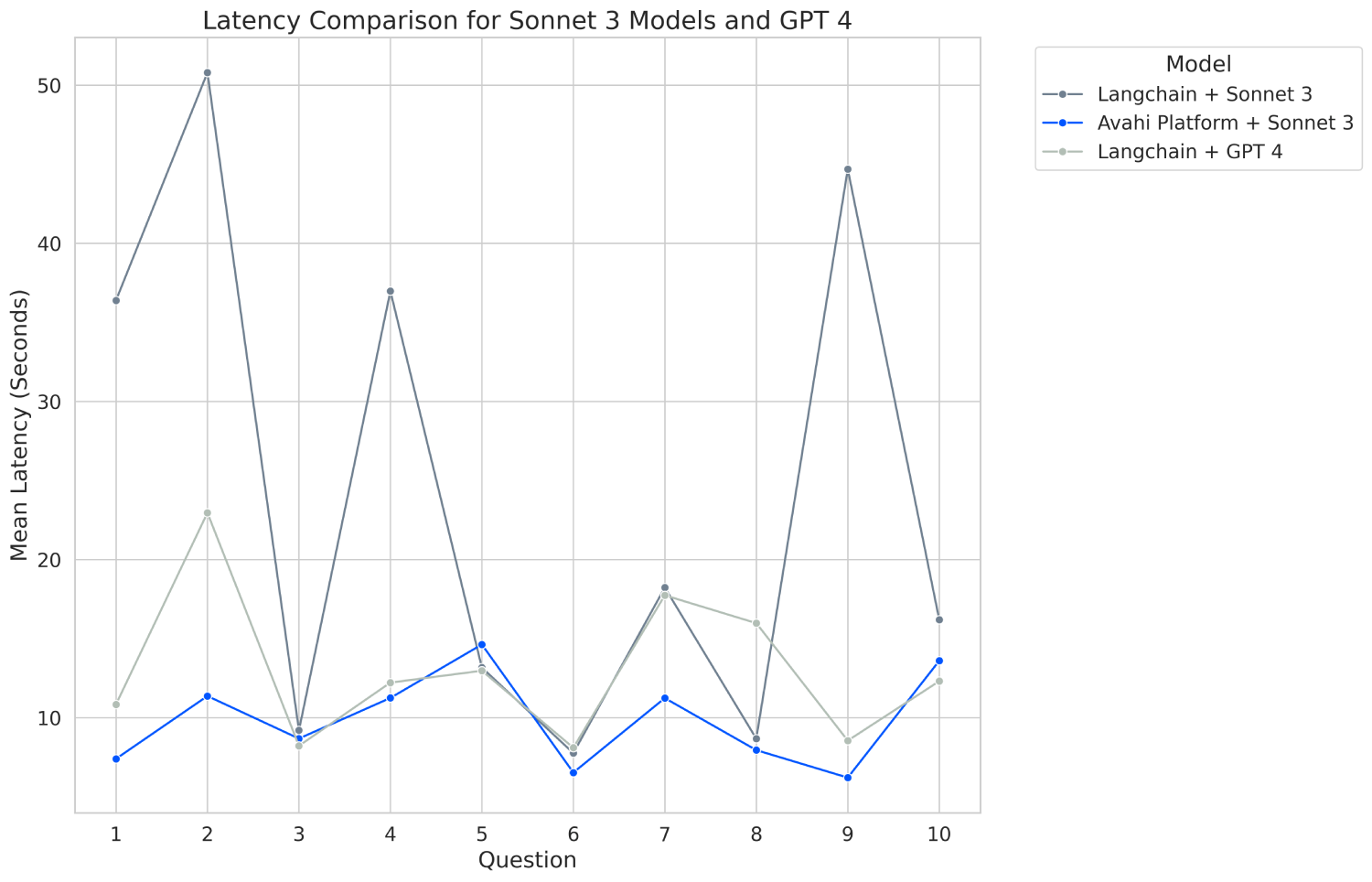

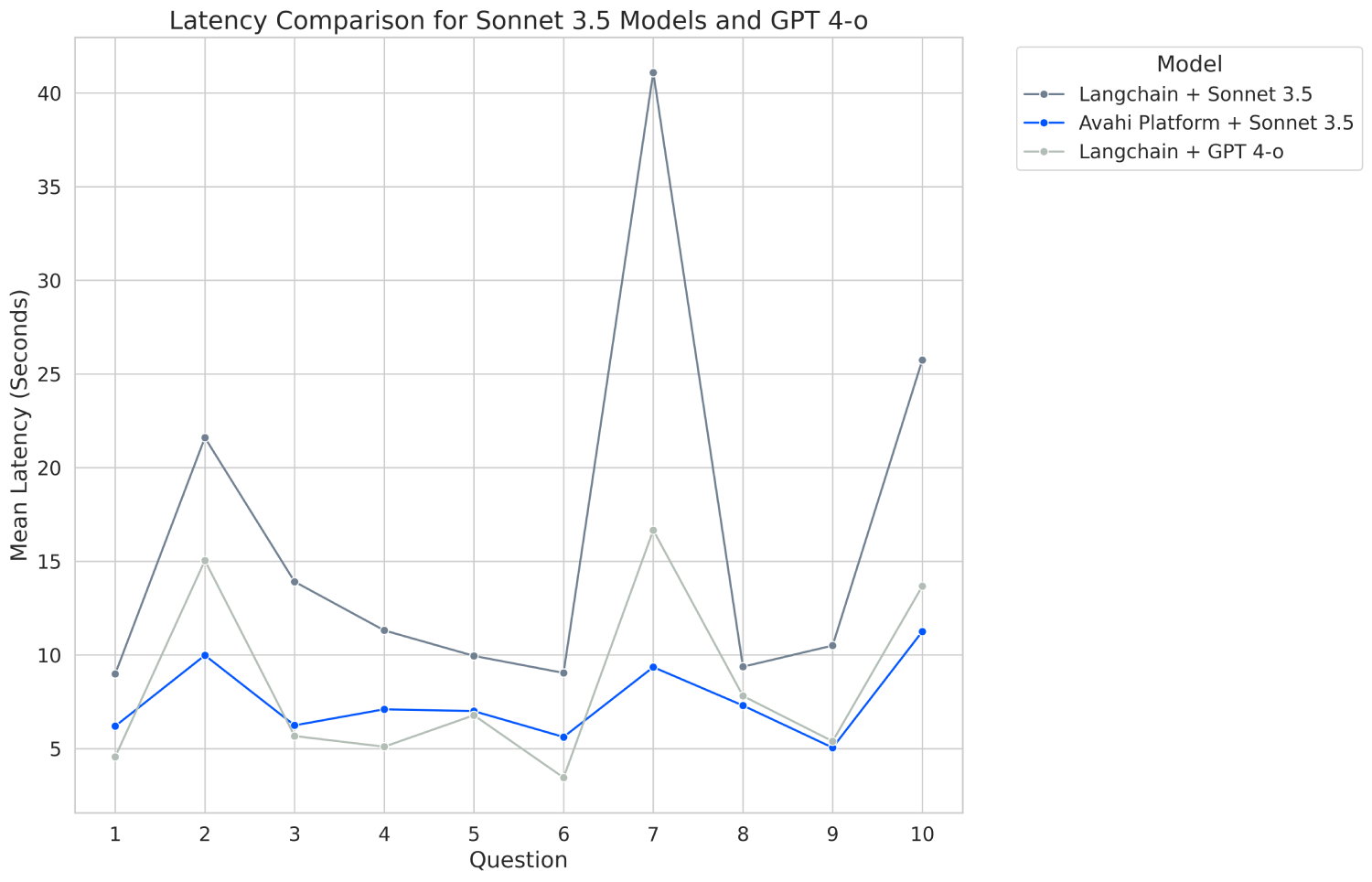

En este blog, presentamos CSV Query de AvahiPlatform; AvahiPlatform es un SDK de Python de última generación diseñado para superar las capacidades de las soluciones existentes como Langchain. Sus capacidades de consulta CSV logran hasta una reducción del 61% en la latencia en comparación con el famoso agente de pandas de Langchain. Operando completamente dentro del entorno seguro de AWS, Avahi Platform mejora significativamente la seguridad y el cumplimiento de los datos, abordando las preocupaciones críticas en el desarrollo de la IA.

Nuestra evaluación exhaustiva implica pruebas de rendimiento rigurosas utilizando los modelos avanzados de Amazon Bedrock (Haiku 3.0, Sonnet 3.0 y Sonnet 3.5) y modelos similares de OpenAI (GPT 3.5, GPT 4 y GPT 4-o) en 10 consultas complejas diferentes. Los resultados demuestran el rendimiento superior y la experiencia de desarrollo optimizada de AvahiPlatform. Concluimos que Avahi Platform CSV Query es una solución viable que supera la herramienta más común para la consulta CSV.

Introducción

Antecedentes

El advenimiento de la IA generativa ha marcado el comienzo de una nueva era de automatización e inteligencia, con aplicaciones que van desde el procesamiento del lenguaje natural hasta la generación de imágenes. Marcos como Langchain han desempeñado un papel fundamental en la democratización del desarrollo de la IA, proporcionando herramientas que simplifican la integración de las capacidades de la IA en las aplicaciones. La prominencia de Langchain se refleja en su importante comunidad de GitHub y su uso generalizado, convirtiéndose en la opción de facto para muchos desarrolladores.

Sin embargo, a medida que las aplicaciones de IA se vuelven más sofisticadas, las limitaciones de los marcos existentes se hacen evidentes. Los desarrolladores se enfrentan a desafíos relacionados con las ineficiencias de rendimiento, los requisitos de codificación complejos y las vulnerabilidades de seguridad, particularmente cuando se manejan datos confidenciales o se opera en industrias reguladas.

Motivación

La motivación detrás de Avahi Platform surge de una clara necesidad de un marco de trabajo avanzado que aborde estos desafíos de frente. Avahi Platform busca proporcionar una solución que no solo iguale, sino que supere las capacidades de las herramientas existentes como Langchain. Al centrarse en la velocidad, la simplicidad y la seguridad, Avahi Platform tiene como objetivo optimizar el proceso de desarrollo, mejorar el rendimiento de las aplicaciones y garantizar una protección de datos robusta.

Al operar completamente dentro del ecosistema de AWS y aprovechar los modelos avanzados de Amazon Bedrock, Avahi Platform ofrece un entorno integrado que admite las últimas innovaciones de IA al tiempo que se adhiere a estrictos estándares de seguridad. Esta alineación con los servicios de AWS garantiza que los datos permanezcan dentro de una infraestructura segura y compatible, mitigando los riesgos asociados con las filtraciones de datos y el acceso no autorizado.

Objetivos

El objetivo principal de este estudio es:

- Evaluación del rendimiento: Evaluar cuantitativamente el rendimiento de AvahiPlatform en comparación con Langchain en términos de latencia en varias tareas de GenAI.

Metodología

Criterios de evaluación

Para proporcionar una comparación exhaustiva entre Avahi Platform y Langchain, realizamos experimentos basados en los siguientes criterios:

- Latencia: El tiempo que se tarda en ejecutar tareas GenAI específicas, medido en segundos. Esta métrica evalúa la eficiencia del procesamiento y la capacidad de respuesta.

- Consulta compleja: Una consulta que requiere más de un campo del archivo CSV proporcionado, así como al menos tres comandos de codificación: ya sea la agrupación por valores o la aplicación de operaciones a las filas CSV. También se proporciona poca información de la propia consulta: la herramienta principal (Langchain/Avahi Platform) debe proporcionar suficiente contexto al LLM para generar una respuesta coherente y precisa.

- Número de ejecuciones: Ejecutamos el experimento 20 veces para cada consulta y tomamos el promedio, asegurándonos de cubrir todos los casos extremos y escenarios. Este enfoque nos permite presentar resultados basados en 20 ejecuciones para cada pregunta, en lugar de depender de una sola ejecución.

Configuración experimental

Configuración del entorno

Todos los experimentos se llevaron a cabo dentro del ecosistema de AWS para garantizar la coherencia y la fiabilidad. Tanto para Avahi Platform como para Langchain, utilizamos los modelos de lenguaje grande (LLM) avanzados de Amazon Bedrock:

- Haiku 3.0

- Sonnet 3.0

- Sonnet 3.5

Se realizó una comparación con el competidor más popular, OpenAI, utilizando los modelos:

- GPT 3.5

- GPT 4

- GPT 4o

Medidas de coherencia

Para mantener comparaciones justas:

- Especificaciones de hardware: Las pruebas se realizaron en recursos computacionales equivalentes (AWS Sagemaker) para eliminar la variabilidad inducida por el hardware.

- Preparación de datos: Se utilizó el mismo conjunto de datos para todas las tareas, lo que garantiza la coherencia en la entrada en ambas plataformas

Tarea evaluada

Consulta CSV: Interpretación de consultas en lenguaje natural para extraer información de datos CSV.

Resultados

Comparación de latencia

La latencia se midió cronometrando la ejecución de cada tarea desde el inicio hasta la finalización. Los resultados se presentan en la Tabla 1

Tabla: Comparación de latencia (en segundos)

| Pregunta | Langchain + haiku | Avahi platform + haiku | Langchain + GPT 3.5-turbo | Langchain + Sonnet 3 | Avahi platform + Sonnet 3 | Langchain + GPT 4 | Langchain + Sonnet 3.5 | Avahi platform + Sonnet 3.5 | Langchain + GPT 4.0 |

| 1 | 4.68 | 3.62 | 3.67 | 8.67 | 7.95 | 15.98 | 9.37 | 7.3 | 7.81 |

| 2 | 15.59 | 2.51 | 4.72 | 44.69 | 6.21 | 8.55 | 10.5 | 5.05 | 5.39 |

| 3 | 536 | 2.91 | 3.81 | 9.2 | 8.68 | 8.22 | 13.91 | 6.24 | 5.67 |

| 4 | 28.87 | 4.48 | 11.08 | 5.08 | 11.37 | 22.96 | 21.6 | 9.98 | 15.04 |

| 5 | 31.05 | 5.4 | 7.21 | 18.23 | 11.24 | 17.74 | 41.09 | 9.35 | 16.66 |

| 6 | 16.31 | 4.24 | 4.66 | 16.2 | 13.6 | 12.31 | 25.74 | 11.25 | 13.67 |

| 7 | 25.2 | 2.8 | 3.01 | 7.76 | 6.53 | 8.1 | 9.04 | 5.62 | 3.45 |

| 8 | 8.52 | 4.18 | 4.63 | 36.39 | 7.4 | 10.84 | 8.99 | 6.2 | 4.56 |

| 9 | 5.53 | 5.91 | 3.75 | 13.17 | 14.63 | 12.97 | 9.95 | 7 | 6.78 |

| 10 | 3.66 | 3.98 | 4.01 | 36.98 | 11.25 | 12.22 | 11.31 | 71 | 5.1 |

Fiabilidad

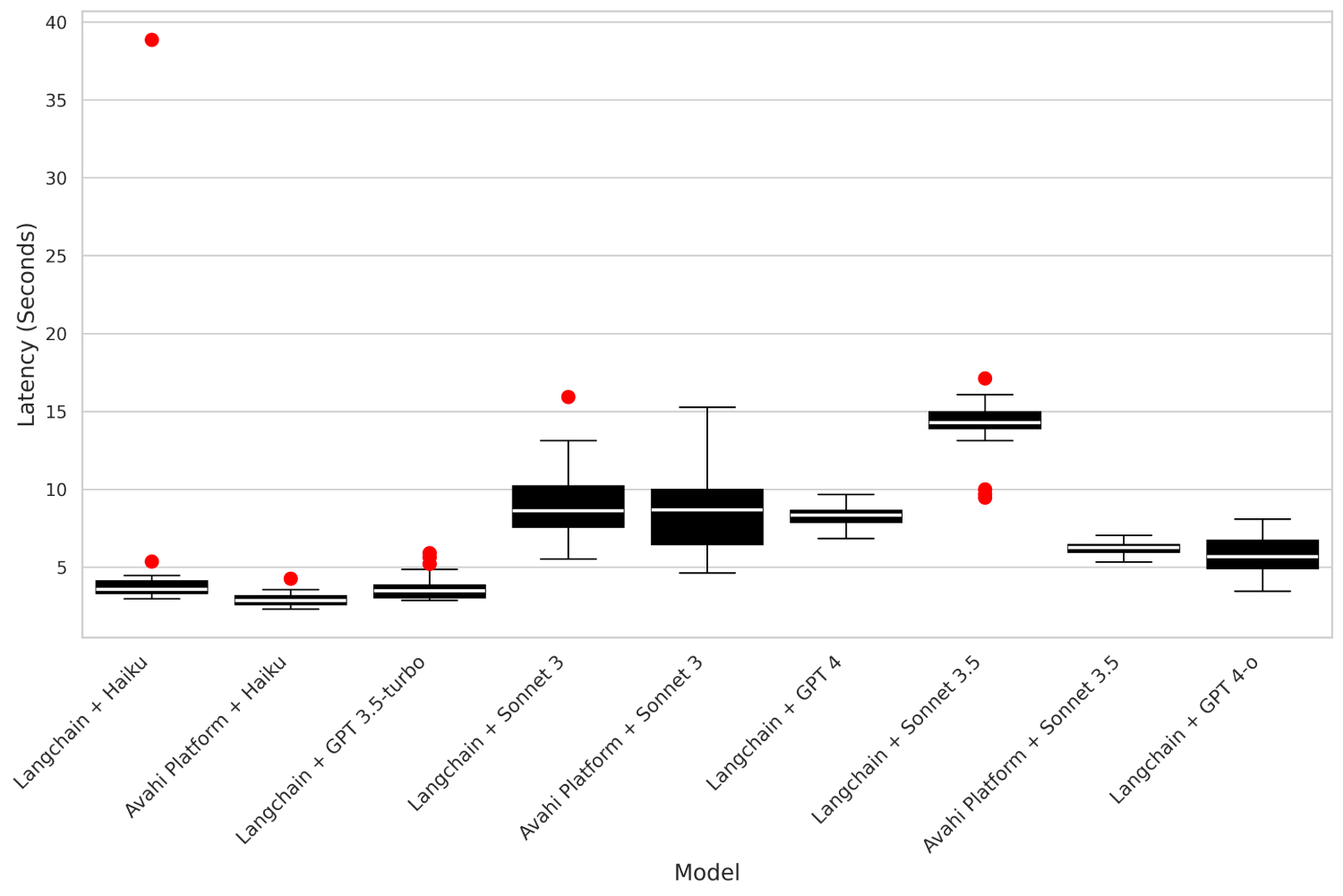

Latencia en 20 experimentos para la pregunta “Obtenga el promedio de la puntuación del examen para todos los géneros con y

sin discapacidades de aprendizaje“

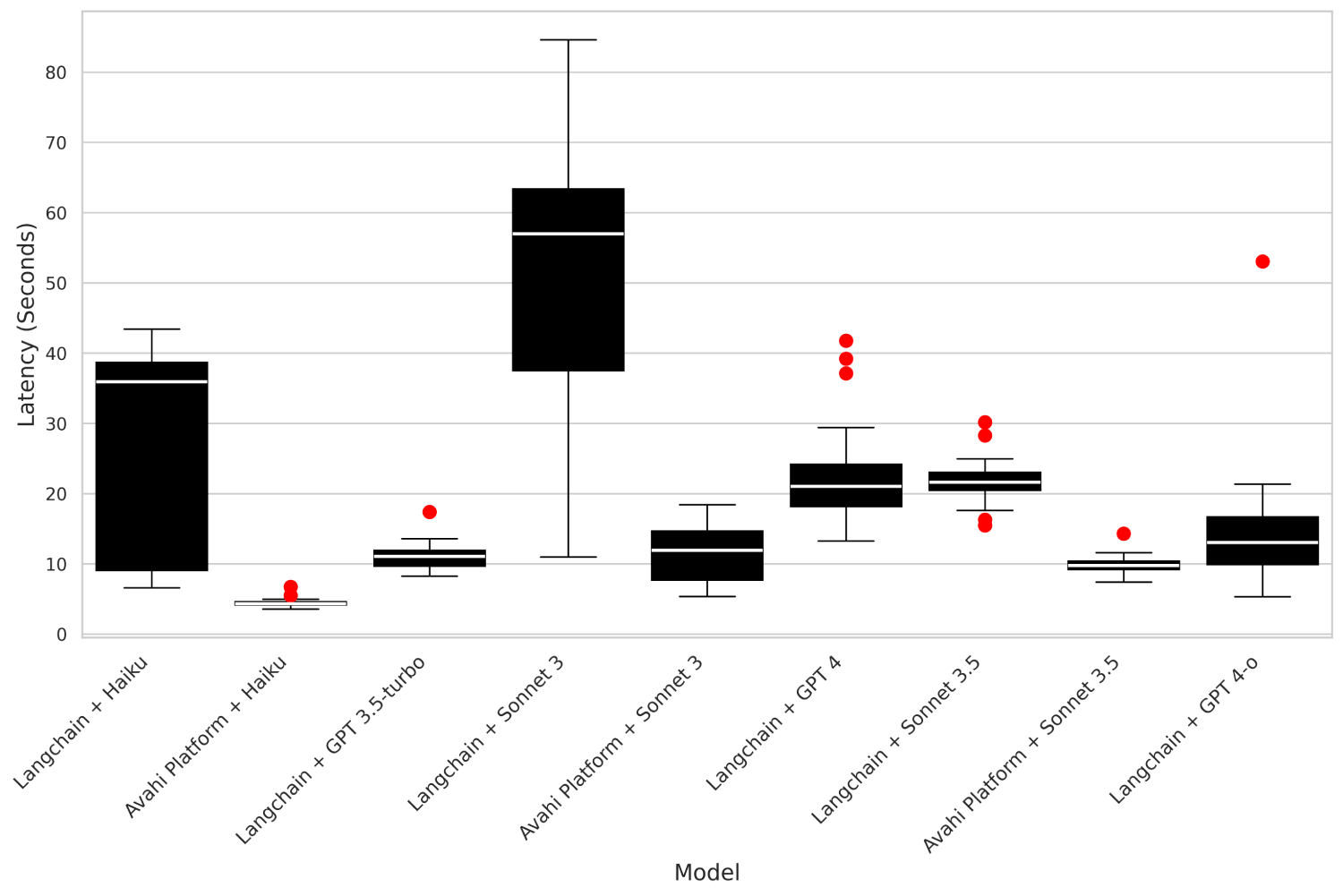

Latencia en 20 experimentos para la pregunta “¿Cómo se correlaciona la influencia de los compañeros con el nivel de educación

de los padres para los estudiantes que asisten a escuelas públicas?“

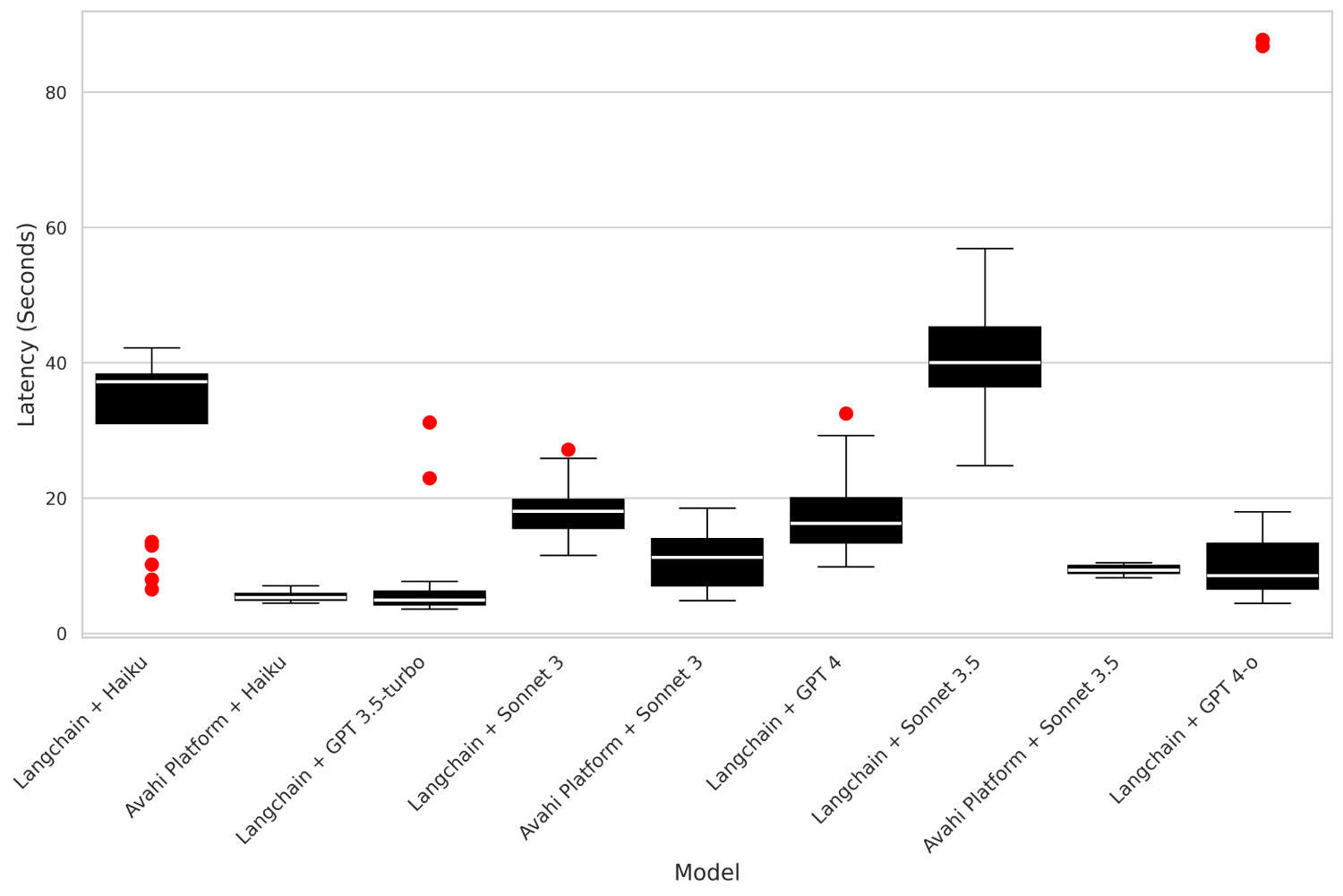

Latencia en 20 experimentos para la pregunta “¿Quién tiene un promedio más alto en actividad física, estudiantes

con acceso a Internet Y más de 2 sesiones de tutoría O estudiantes sin acceso a Internet Y 2 o menos

sesiones de tutoría?“

- Menor latencia: Avahi Platform muestra constantemente una latencia media más baja en la tarea de consulta CSV, lo que significa que se completa más rápido en promedio. Esto la convierte en una mejor opción para aplicaciones en tiempo real o de misión crítica.

- Distribución más ajustada: Esta distribución ajustada indica que la plataforma ofrece un tiempo de respuesta más consistente, esencial para las aplicaciones que requieren tiempos de ejecución estables.

- Menos valores atípicos: Avahi Platform también produce menos valores atípicos de latencia, lo que indica que es menos propensa a ralentizaciones inesperadas del rendimiento. Esto garantiza que los usuarios puedan confiar en que la plataforma proporcionará resultados estables en diversas condiciones.

Ventajas de seguridad y red

Operando completamente dentro del entorno de AWS, AvahiPlatform aprovecha las medidas de seguridad integrales de AWS, ofreciendo las siguientes ventajas:

- Integridad de los datos: Todas las operaciones están confinadas dentro de AWS, lo que garantiza que los datos no estén expuestos a servidores externos ni se utilicen para fines no deseados.

- Cumplimiento: AvahiPlatform se adhiere a los estándares de la industria y las regulaciones de cumplimiento (por ejemplo, GDPR, HIPAA), beneficiándose de las certificaciones y los programas de cumplimiento de AWS.

- Superficie de ataque reducida: Al minimizar el movimiento de datos externos y confiar en la infraestructura segura de AWS, el riesgo de filtraciones de datos y acceso no autorizado se reduce significativamente.

En contraste, Langchain puede implicar interacciones con API o servicios externos, lo que podría introducir vulnerabilidades o desafíos de cumplimiento.

Discusión

Rendimiento y eficiencia

Las mejoras de latencia observadas en AvahiPlatform pueden atribuirse a su integración optimizada con los servicios de AWS y al manejo eficiente de las invocaciones de modelos. Al reducir la sobrecarga y optimizar las operaciones, AvahiPlatform ofrece respuestas más rápidas, que son aplicaciones en tiempo real y mejoran la experiencia del usuario.

Mejoras de seguridad

La seguridad de los datos es primordial en el mundo interconectado de hoy. La operación exclusiva de Avahi Platform dentro del entorno de AWS garantiza que los datos permanezcan protegidos bajo los robustos protocolos de seguridad de AWS. La información confidencial se maneja con cuidado, beneficiándose del cifrado, los mecanismos de autenticación segura y el cumplimiento de los estándares internacionales.

Al minimizar la exposición de los datos y eliminar la necesidad de transmitir datos a servicios externos, Avahi Platform reduce el riesgo de filtraciones de datos. Esto es particularmente importante para las industrias que manejan información confidencial, como la atención médica y las finanzas.

Experiencia del desarrollador

El énfasis de Avahi Platform en la simplicidad y la facilidad de uso reduce la barrera de entrada para el desarrollo de aplicaciones de IA. Los desarrolladores pueden crear prototipos e implementar aplicaciones rápidamente sin una profunda experiencia en IA o una codificación extensa. La provisión de configuraciones predeterminadas y la integración con herramientas familiares mejoran aún más la experiencia del desarrollador.

Conclusión

Avahi Platform representa un avance significativo en los marcos de trabajo de GenAI, abordando las limitaciones clave de las soluciones existentes como Langchain. A través de pruebas y evaluaciones rigurosas, hemos demostrado que AvahiPlatform ofrece:

- Rendimiento mejorado: Logra hasta <insert-value> reducción en la latencia en tareas comunes, mejorando la capacidad de respuesta de la aplicación.

La alineación de AvahiPlatform con los servicios de AWS y la utilización de los modelos avanzados de Amazon Bedrock garantizan que los desarrolladores tengan acceso a capacidades de IA de vanguardia dentro de un marco de trabajo seguro y eficiente. Al simplificar el proceso de desarrollo y mejorar el rendimiento, Avahi Platform permite a los desarrolladores centrarse en la innovación y acelerar la implementación de soluciones de IA.

A medida que la IA continúa impregnando varios aspectos de la tecnología y la industria, los marcos de trabajo como Avahi Platform desempeñarán un papel esencial para facilitar este crecimiento. El trabajo futuro puede implicar una mayor optimización, la expansión de conjuntos de características y la exploración de integraciones con otros servicios en la nube para continuar mejorando el desarrollo de aplicaciones de IA.

Referencias

Repositorio de Langchain en GitHub. [ GitHub – langchain-ai/langchain: Build context-aware reasoning applications ]( GitHub – langchain-ai/langchain: Build context-aware reasoning applications )

Repositorio de Langchain AWS en GitHub. [ GitHub – langchain-ai/langchain-aws: Build LangChain Applications on AWS ]

Documentación de Amazon Bedrock. [ build generative AI applications with foundation models – Amazon bedrock – AWS ]( build generative AI applications with foundation models – Amazon bedrock – AWS )

Repositorio de AvahiPlatform en GitHub. [ GitHub – avahi-org/avahiplatform: With AvahiPlatform, you can create and deploy GenAI applications on Bedrock in just 60 seconds. It’s that fast and easy! ]

( GitHub – avahi-org/avahiplatform: With AvahiPlatform, you can create and deploy GenAI applications on Bedrock in just 60 seconds. It’s that fast and easy! )