TL;DR

|

Los sistemas de IA agentic no fallan silenciosamente. Cuando fallan, actúan.

A diferencia de la IA tradicional, las herramientas de IA agentic pueden tomar decisiones, llamar a herramientas y ejecutar acciones de forma independiente. En entornos de producción, esto significa que un solo error no es solo una respuesta incorrecta. Puede desencadenar flujos de trabajo incorrectos, acciones no deseadas o infracciones de políticas a escala.

Informes recientes del sector muestran que los problemas de precisión del modelo representan solo una pequeña parte de los incidentes de producción relacionados con la IA; más bien, los fallos en la lógica de decisión, el uso indebido de herramientas y la mala supervisión en los sistemas autónomos son las principales causas. A medida que las organizaciones pasan de la IA basada en indicaciones a los sistemas basados en agentes, estos riesgos aumentan, no disminuyen.

Si está creando o implementando herramientas de IA agentic, ya no está evaluando un modelo. Está evaluando un sistema que planifica, actúa y se adapta con el tiempo.

Este cambio modifica lo que significa “calidad”. La precisión por sí sola no es suficiente. Necesita saber si el sistema se comporta de forma segura, predecible y fiable en condiciones reales.

Este blog se centra en cómo evaluar las herramientas de IA agentic para sistemas de nivel de producción y desglosa los desafíos principales, los marcos de evaluación prácticos y las métricas que importan cuando la autonomía está involucrada.

Características de las herramientas de IA agentic

Si está evaluando herramientas de IA agentic para sistemas reales, el primer desafío es comprender qué las diferencia de los modelos de IA estándar. Las herramientas agentic no son solo modelos que responden a indicaciones. Son sistemas diseñados para actuar, decidir y ajustarse con el tiempo mientras trabajan para alcanzar un objetivo definido. Aquí está la lista de características principales de las herramientas de IA agentic:

1. Autonomía

Usted le da al sistema un objetivo de alto nivel, no instrucciones paso a paso. El agente divide ese objetivo en acciones más pequeñas y decide cuándo y cómo ejecutarlas. Su función cambia de dirigir cada paso a establecer límites y criterios de éxito.

2. Comportamiento dirigido a objetivos

El agente planifica una secuencia de acciones en lugar de generar una sola respuesta. Cada paso se elige en función del progreso hacia el objetivo, no solo de la entrada inmediata. Usted evalúa si el plan y la ejecución se alinean con el resultado previsto, no solo con el resultado final.

3. Adaptabilidad

El agente cambia sus acciones cuando cambian las entradas, las herramientas o el contexto. Si una herramienta falla o devuelve resultados inesperados, el agente ajusta su plan en lugar de detenerse. Debe evaluar lo bien que se recupera, no solo con qué frecuencia tiene éxito.

¿En qué se diferencian las herramientas de IA agentic de los sistemas de IA convencionales?

Comprender esta diferencia le ayuda a evitar el uso de métodos de evaluación incorrectos.

| Aspecto | Sistemas de IA convencionales | Herramientas de IA agentic |

| Interacción principal | Usted proporciona una entrada y recibe una sola salida, como texto, una etiqueta o una puntuación. | El sistema realiza acciones utilizando herramientas externas, API o entornos de ejecución. |

| Manejo del estado | No conserva un estado a largo plazo entre las interacciones. | Mantiene el estado entre los pasos y utiliza las decisiones pasadas para guiar las acciones futuras. |

| Ámbito de decisión | Responde solo a la entrada actual. | Planifica y ejecuta acciones de varios pasos hacia un objetivo. |

| Foco de evaluación | Precisión de la salida, relevancia o similitud con los resultados esperados. | Rutas de decisión, uso de herramientas, comportamiento de recuperación y alineación de objetivos. |

| Impacto del error | Los errores suelen afectar a una sola respuesta. | Los errores pueden propagarse a través de los pasos y afectar a todo el flujo de trabajo. |

| Comportamiento del sistema | Reactivo. | Autónomo y orientado a objetivos. |

Desafíos en la evaluación de la IA agentic

Al evaluar la IA agentic para sistemas de producción, la dificultad no radica únicamente en la calidad del modelo. El desafío proviene de cómo estos sistemas actúan, se adaptan y evolucionan. Cada desafío a continuación explica lo que necesita tener en cuenta antes de confiar en un agente en un entorno real.

1. Espacio complejo de entrada y acción

Los sistemas de IA agentic a menudo tienen múltiples formas válidas de alcanzar el mismo objetivo. La misma entrada puede conducir a diferentes acciones dependiendo del contexto, el estado o la disponibilidad de la herramienta.

No puede confiar en una sola salida esperada. Su evaluación debe cubrir una amplia gama de entradas, acciones y rutas de decisión para comprender el comportamiento real.

2. Procesos de decisión de varios pasos

Los sistemas agentic toman decisiones a través de una secuencia de pasos en lugar de forma aislada. Un resultado correcto aún puede ocultar un razonamiento deficiente, acciones arriesgadas o rutas ineficientes. Debe evaluar las decisiones intermedias, las llamadas a herramientas y los cambios de estado, no solo el resultado.

3. Interdependencias de los componentes

El comportamiento de un agente depende de cómo interactúan la lógica de planificación, la memoria, las herramientas y las reglas de decisión. Un fallo en un solo componente puede alterar el comportamiento de todo el sistema.

Debe probar cada componente individualmente, luego evaluar cómo funcionan juntos como un flujo de trabajo completo.

4. Evolución con el tiempo

Los sistemas de IA agentic cambian a medida que se actualizan los modelos, las herramientas evolucionan y los patrones de datos cambian. El comportamiento que era seguro o eficaz durante las pruebas puede desviarse en la producción.

Necesita evaluación y supervisión continuas para detectar cambios en el rendimiento, el comportamiento y el riesgo.

5. Riesgos de seguridad y alineación

La autonomía aumenta el impacto de los errores y la desalineación. Un agente puede tomar acciones no deseadas, usar indebidamente herramientas o violar políticas sin supervisión directa.

Su evaluación debe incluir comprobaciones de seguridad, pruebas de cumplimiento de políticas y escenarios de fallo, no solo métricas de rendimiento.

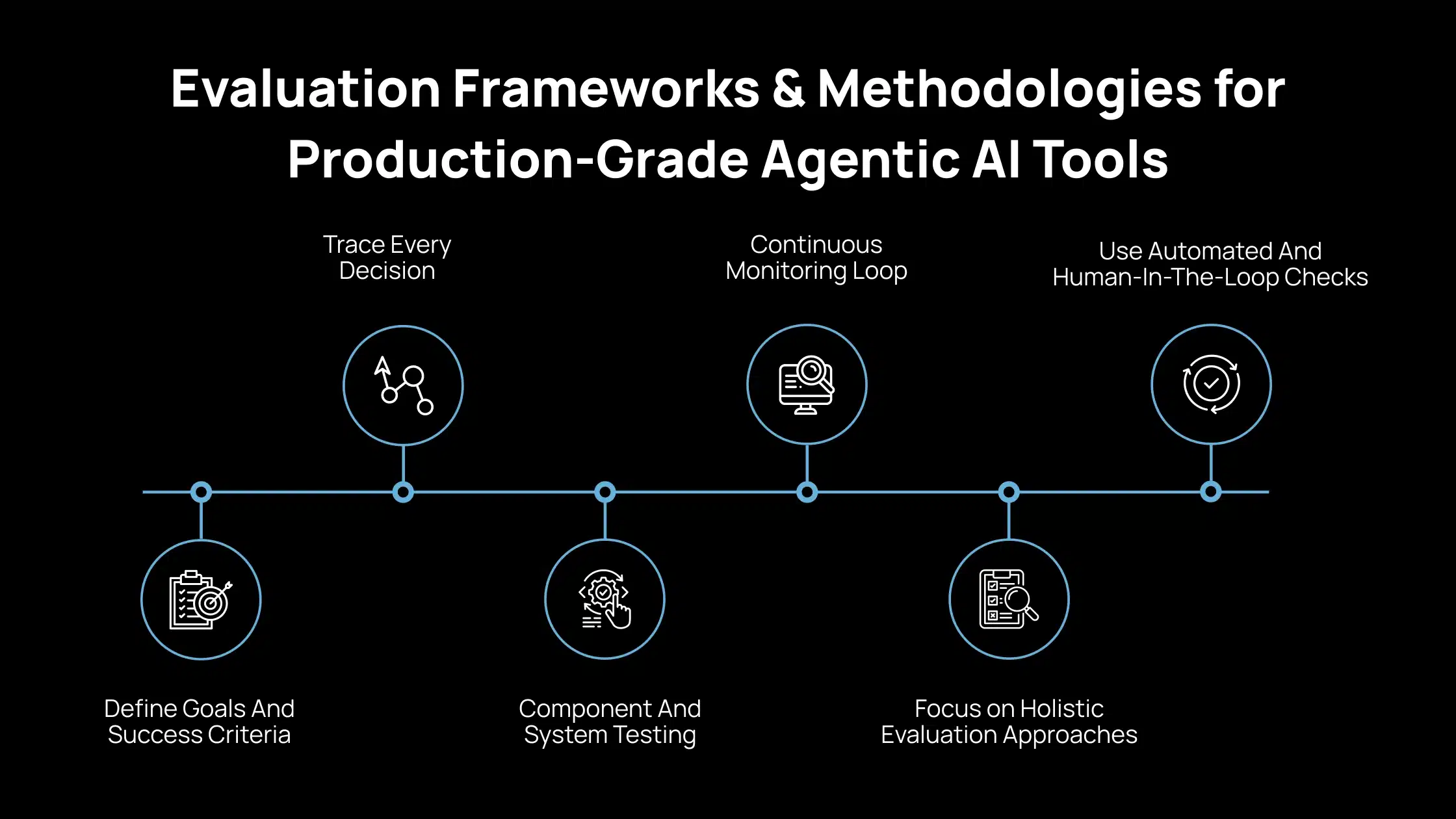

Marcos de evaluación y metodologías para herramientas de IA agentic de nivel de producción

Cuando evalúa herramientas de IA agentic para la producción, las pruebas ad hoc no son suficientes. Necesita un marco estructurado que refleje cómo estos sistemas planifican, actúan y cambian con el tiempo. Esta sección describe un enfoque de evaluación práctico que puede aplicar directamente a las implementaciones reales.

1. Defina los objetivos y los criterios de éxito

Comience por definir lo que significa el éxito a nivel de sistema. Concéntrese en los resultados de extremo a extremo, no en las respuestas de modelos individuales. Debe poder indicar, en términos sencillos, lo que el agente debe lograr y cómo es el fallo.

2. Trace cada decisión

Instrumente el sistema para registrar planes, selecciones de herramientas, subtareas y comportamientos predeterminados. Este seguimiento le permite comprender por qué el agente actuó de cierta manera. Sin rastreos de decisiones, no puede depurar o mejorar de forma fiable el comportamiento del agente.

3. Pruebas de componentes y sistemas

Pruebe cada componente de forma independiente, incluida la lógica de planificación, el manejo de la memoria y las interfaces de herramientas. Luego, evalúe el flujo de trabajo completo para ver cómo interactúan los componentes en condiciones reales. Esto le ayuda a identificar fallos que solo aparecen a nivel del sistema.

4. Bucle de supervisión continua

La evaluación no se detiene después de la implementación. Necesita comprobaciones continuas para detectar cambios de rendimiento, nuevos patrones de fallo y comportamientos inesperados. La supervisión cierra la brecha entre las pruebas y el uso en el mundo real.

5. Concéntrese en enfoques de evaluación holísticos

Debe evaluar la precisión técnica, la fiabilidad y la latencia junto con la seguridad y la calidad de la decisión. Esto incluye cómo el agente maneja la incertidumbre, los errores y las entradas ambiguas. Un enfoque limitado en la calidad de la salida pasa por alto los riesgos críticos del sistema.

6. Utilice comprobaciones automatizadas y con intervención humana

Utilice pruebas automatizadas para cubrir la escala, las regresiones y los casos de fallo conocidos. Incluya la revisión humana para la alineación, el juicio de seguridad y los casos extremos que la automatización no puede capturar completamente. Esta combinación le ayuda a equilibrar la eficiencia con la supervisión responsable.

Evaluación de herramientas de IA agentic utilizando métricas centradas en la producción

Para evaluar las herramientas de IA agentic en la producción, necesita métricas que reflejen cómo funciona el sistema, se comporta bajo carga y se alinea con las limitaciones del mundo real. Las categorías a continuación le ayudan a medir lo que realmente importa cuando un agente opera sin supervisión constante.

1. Métricas de rendimiento técnico

Éxito de la tarea

Esto mide si el agente logra el objetivo previsto de acuerdo con los requisitos predefinidos. Debe definir los criterios de éxito claramente para que los resultados sean coherentes y comparables. Una tarea completada que viola las restricciones u omite los pasos necesarios debe contar como un fallo.

Precisión de la llamada a la herramienta

Esto evalúa si el agente selecciona las herramientas correctas y las utiliza con parámetros válidos.

Las llamadas a herramientas incorrectas o innecesarias aumentan el coste y el riesgo. Debe realizar un seguimiento de los patrones de uso de la herramienta y marcar el uso indebido o los reintentos repetidos.

Coherencia del plan

Esto mide si el agente sigue una secuencia de pasos lógica y coherente. Un plan coherente muestra que las decisiones están conectadas y alineadas con el objetivo. La planificación incoherente a menudo señala errores ocultos, razonamiento débil o salvaguardias faltantes.

2. Métricas operativas y de fiabilidad

Latencia y rendimiento

La latencia es el tiempo que tarda el agente en completar las tareas. El rendimiento mide cuántas tareas puede manejar bajo carga. Necesita ambos para comprender si el sistema puede cumplir con los requisitos de rendimiento de producción.

Tasas de fallo

Esto rastrea con qué frecuencia el agente alcanza los tiempos de espera, los reintentos o las rutas de reserva. Las altas tasas de fallo indican inestabilidad, problemas de herramientas o lógica de planificación débil. Debe medir los fallos por tarea, no solo por solicitud.

Cobertura de seguimiento

Esto mide cuánto del comportamiento del agente es visible a través de registros y rastreos. La cobertura de seguimiento completa le permite diagnosticar errores y comprender las rutas de decisión. La baja cobertura limita su capacidad para depurar y mejorar el sistema.

3. Métricas de seguridad y alineación

Cumplimiento de la política

Esto evalúa si el agente sigue constantemente las reglas y restricciones definidas. Las políticas pueden incluir límites de acceso a datos, límites de acción o restricciones de contenido. Cualquier violación de la política debe tratarse como un problema de alta gravedad.

Frecuencia de escalada de riesgo

Esto mide con qué frecuencia el agente requiere revisión o intervención humana. La escalada frecuente puede indicar una baja confianza en la toma de decisiones o un comportamiento inseguro. El seguimiento de esto le ayuda a decidir dónde es apropiada la automatización y dónde se necesitan controles.

4. Dimensiones humanas y económicas

Puntuaciones de confianza del usuario

Estas puntuaciones reflejan cómo los revisores humanos evalúan las decisiones y acciones del agente. La confianza se construye a través de la coherencia, la claridad y el comportamiento predecible. La baja confianza a menudo apunta a lagunas de explicabilidad o alineación.

Coste por éxito

Esto mide el coste total requerido para cada tarea completada. Debe incluir el uso del modelo, las llamadas a herramientas, los reintentos y los costes de infraestructura. Esta métrica le ayuda a evaluar si el agente ofrece valor práctico a escala.

Lista de verificación de preimplementación y supervisión para validar herramientas de IA agentic en producción

Utilice esta lista de verificación para validar las herramientas de IA agentic antes de la implementación y para mantener el control una vez que el sistema esté en funcionamiento. Cada elemento se centra en reducir el riesgo y aumentar la visibilidad en condiciones de producción reales.

1. Pruebas previas a la implementación

|

2. Supervisión continua de la producción

|

¿Cómo le ayuda Avahi a convertir la IA en resultados empresariales reales?

Si su objetivo es aplicar la IA de manera práctica que ofrezca un impacto empresarial medible, Avahi ofrece soluciones diseñadas específicamente para los desafíos del mundo real.Avahi permite a las organizaciones adoptar de forma rápida y segura capacidades avanzadas de IA, respaldadas por una sólida base en la nube y una profunda experiencia en AWS.

Las soluciones de IA de Avahi ofrecen beneficios empresariales como:

- Interacción con el cliente las 24 horas del día

- Captura automatizada de clientes potenciales y gestión de llamadas

- Creación de contenido más rápida

- Conversión rápida de documentos en datos utilizables

- Planificación más inteligente a través de información predictiva

- Comprensión más profunda del contenido visual

- Acceso sin esfuerzo a los datos a través de consultas en lenguaje natural

- Protección de datos integrada y cumplimiento normativo

- Comunicación global fluida a través de la traducción y localización avanzadas

Al asociarse con Avahi, las organizaciones obtienen acceso a un equipo con amplia experiencia en IA y la nube comprometido con la entrega de soluciones personalizadas. El enfoque se mantiene en los resultados medibles, desde la automatización que ahorra tiempo y reduce los costes hasta el análisis que mejora la toma de decisiones estratégicas y las interacciones impulsadas por la IA que elevan la experiencia del cliente.

Descubra la plataforma de IA de Avahi en acción

EnAvahi, capacitamos a las empresas para implementar IA generativa avanzada que agiliza las operaciones, mejora la toma de decisiones y acelera la innovación, todo ello con cero complejidad.

Como su socio de consultoría de AWS Cloud de confianza, capacitamos a las organizaciones para que aprovechen todo el potencial de la IA, garantizando al mismo tiempo la seguridad, la escalabilidad y el cumplimiento con las soluciones en la nube líderes del sector.

Nuestras soluciones de IA incluyen

- Adopción e integración de la IA : aproveche Amazon Bedrock y GenAI para mejorar la automatización y la toma de decisiones.

- Desarrollo de IA personalizado : cree aplicaciones inteligentes adaptadas a las necesidades de su negocio.

- Optimización de modelos de IA – Cambie sin problemas entre modelos de IA con comparaciones automatizadas de costes, precisión y rendimiento.

- Automatización de la IA – Automatice las tareas repetitivas y libere tiempo para el crecimiento estratégico.

- Seguridad avanzada y gobernanza de la IA – Garantice el cumplimiento, detecte el fraude e implemente modelos seguros.

¿Quiere desbloquear el poder de la IA con seguridad y eficiencia de nivel empresarial?

¡Comience hoy mismo su transformación de la IA con avahi!

Preguntas frecuentes

1. ¿Qué hace que la evaluación de las herramientas de IA agentic sea más difícil que la evaluación de los modelos de IA tradicionales?

Las herramientas de IA agentic hacen más que generar salidas. Planifican, llaman a herramientas, mantienen el estado y se adaptan con el tiempo. Debido a que las acciones se combinan a través de los pasos, un solo error puede afectar a todo el flujo de trabajo. Esto significa que debe evaluar el comportamiento, las decisiones y las rutas de recuperación, no solo la precisión.

2. ¿Puedo confiar en las pruebas fuera de línea para validar las herramientas de IA agentic?

No. Las pruebas fuera de línea son necesarias pero no suficientes. El comportamiento de la IA agentic cambia bajo tráfico real, datos reales y fallos de herramientas reales. La validación de la producción requiere una supervisión continua, un seguimiento y una detección de deriva para detectar problemas que no aparecen durante las pruebas.

3. ¿Cuál es la métrica más importante al evaluar las herramientas de IA agentic?

No hay una sola métrica. El éxito de la tarea, la precisión de la llamada a la herramienta, el cumplimiento de la seguridad y el coste por éxito deben evaluarse juntos. Centrarse en una sola métrica a menudo enmascara riesgos críticos, especialmente en los sistemas autónomos.

4. ¿Cómo sé si una herramienta de IA agentic es segura para su uso en producción?

Necesita evidencia de simulaciones de seguridad, pruebas de cumplimiento de políticas y supervisión del mundo real. Un agente listo para la producción debe demostrar un cumplimiento constante de la política, una escalada controlada a los humanos y un comportamiento predecible en casos extremos.

5. ¿Cuándo se debe requerir la revisión humana?

La revisión humana es esencial para las decisiones de alto riesgo, las entradas ambiguas y las acciones delicadas en cuanto a políticas. Si un agente escala con frecuencia o produce decisiones de baja confianza, eso indica lagunas en la alineación, la confianza o el diseño del sistema que necesitan atención.